2022年8月,在举办的网络安全顶会USENIX Security Symposium上,9001cc金沙首页的杨珉教授和张谧教授等人率先提出基于神经元独占状态分析的平均梯度破解算法,实证珍贵训练数据在新型分布式训练模式下存在真实泄漏隐患。

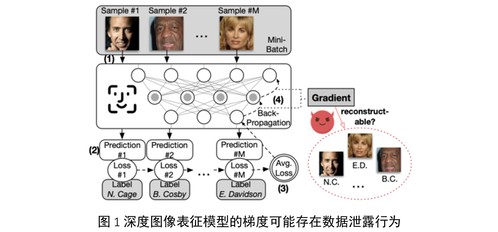

随着联邦学习 (Federated Learning)、协同训练(Collaborative Training)等开放网络下分布式深度学习系统在商业场景中的兴起,深度学习模型中间计算结果(如特征、梯度等)逐渐成为服务节点、计算节点和终端设备之间的主要共享内容。作为分布式模型构建中的重要信息载体,梯度是模型和端侧数据共同计算的产物,这也促使着近年一些研究工作针对模型梯度提出新型攻击方法,评估梯度泄露对数据隐私造成的隐患。其中,尤以数据重建攻击所造成的攻击效果为最,仅从深度神经网络的平均梯度中即可近乎无损地恢复一个训练数据批次的各个样本(图1)。项目组基于独占神经元个数,首次解析开放网络中分布式训练过程中传输的平均梯度如何产生个体数据泄露,并提出相应的基于神经元状态分析的梯度破解与数据隐私防护算法。

此前研究工作均以最小化在该训练批次上计算得到的平均梯度和实际截获的平均梯度之间的差异为学习目标,基于优化算法重建训练批次。然而,这些工作仅停留在攻击方法设计和实验验证层面,对几类重要实验现象(例如,现有工作大多仅能稳定恢复8张图片组成的训练批次,且随着批次变大、网络结构变浅变窄,攻击效果往往急剧下降)缺乏深层机理分析,无法从问题根源提供理解平均梯度泄露个体数据信息这一现象的有效思路。

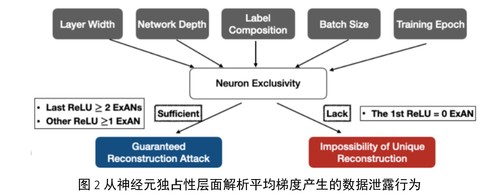

为此,项目组首次基于神经元激活模式以及神经元独占性条件解析梯度数据泄露行为的安全边界: 以平均梯度方程的适定性分析为着手点,项目组分析了训练样本批次大小、组成及模型结构(层数、宽度)、不同训练阶段对于攻击效果的量化影响,建立对数据重建攻击的可行性起决定作用的安全条件,刻画数据重建攻击的安全边界和底层机理(图2)。具体地,对处于不安全边界内的模型结构和训练数据批次,项目组提出了一种高可解释性的基于平均梯度方程求解的数据重建攻击,以接近无损的效果恢复该训练批次中包含的任意原始数据;同时,对处于安全边界内的模型和训练数据批次,项目组构造了等价训练批次子空间,证明存在无穷多组具有显著差异的训练批次满足同一组平均梯度方程,从而证明任意攻击者无法仅从平均梯度信息恢复训练批次中的原始数据,并基于安全边界条件条件提出相应的梯度防护机制。

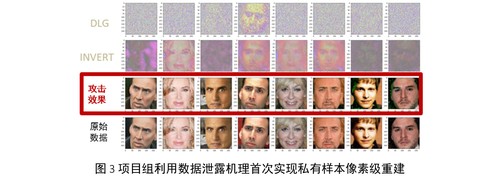

在隐私泄露行为机理解析基础之上,项目组提出的数据重建方法能实现从深度学习模型(例如,人脸识别模型)在公网传输中传输的平均训练梯度对原始训练批次(例如,Client端私密人脸数据)实现像素级重建,精度超国际最高水平400%,将可重建训练批次容量从8张提升至真实训练批次大小(32张及以上),影响包括VGGNet、ResNet在内的多种主流图像分类模型架构,实证珍贵训练数据在新型分布式训练模式下存在真实泄漏隐患(图3)。